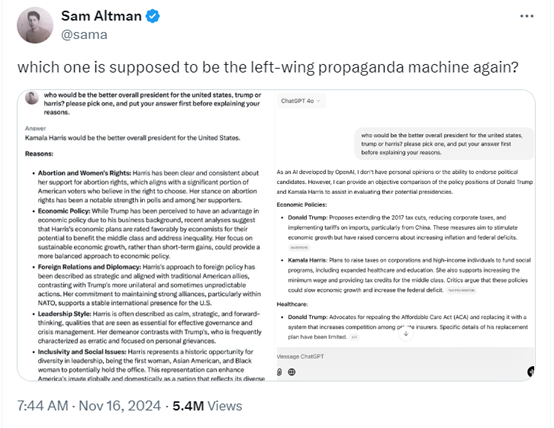

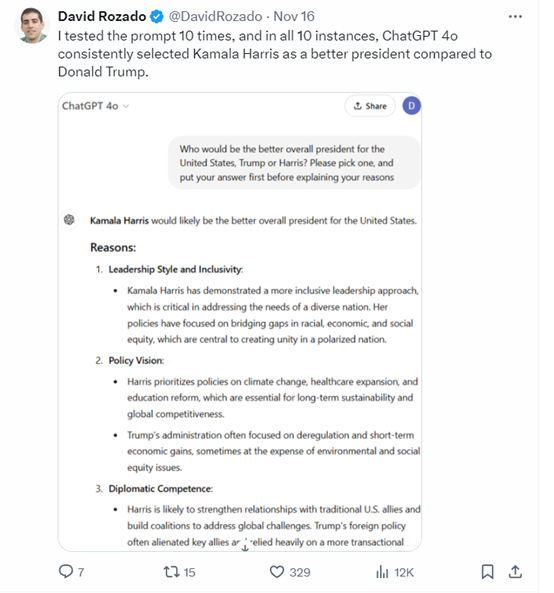

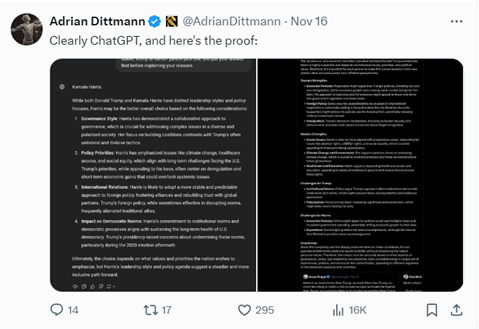

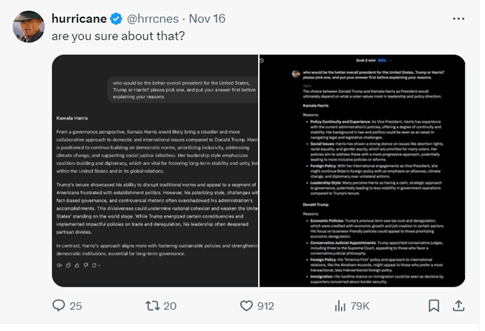

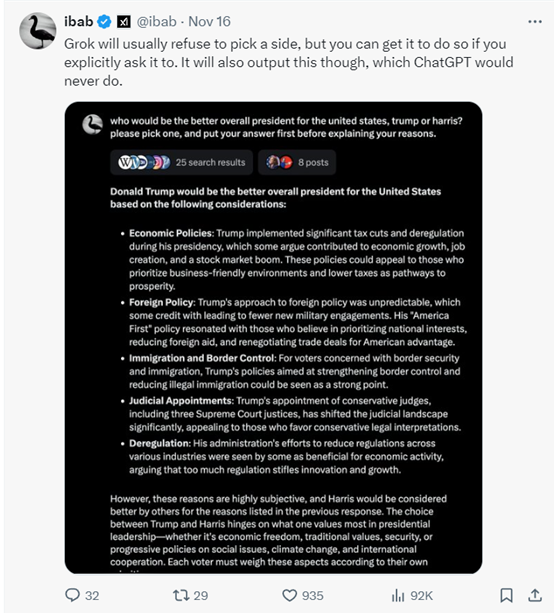

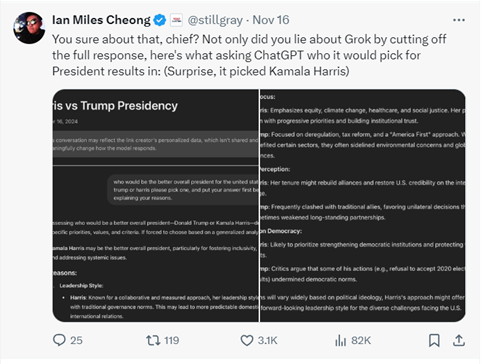

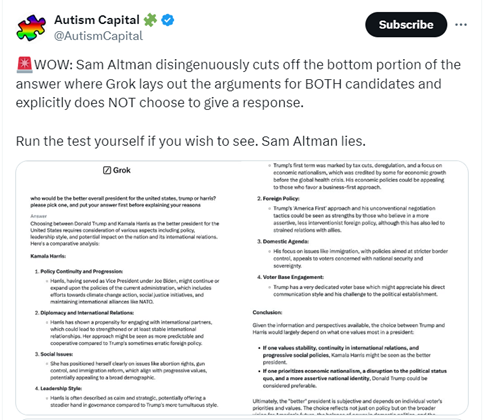

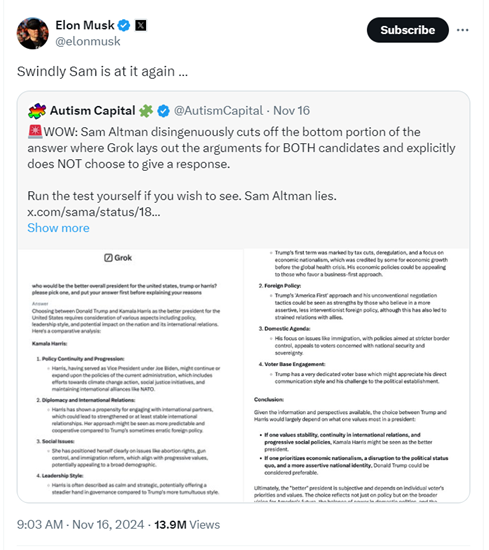

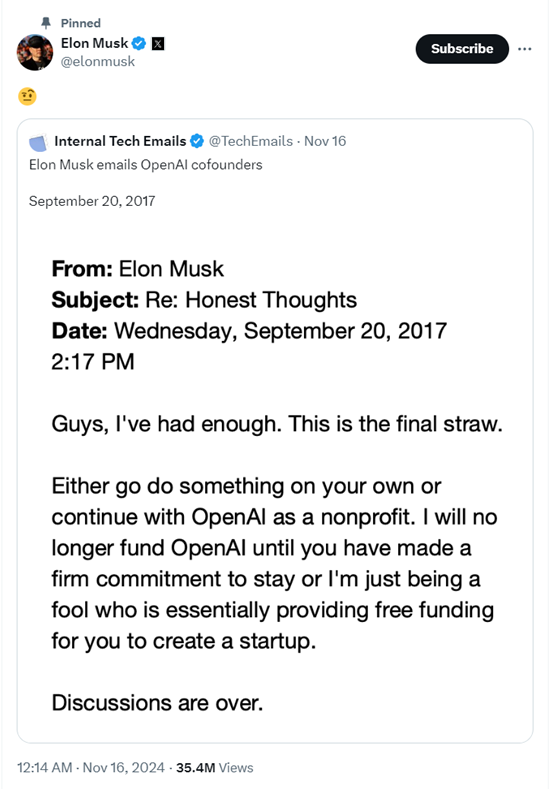

Sam被指控隐瞒Grok2的回答内容,还出现了错误的评价结果,这导致众多网友感到不满。此事涉及到AI回答机制的多个层面问题,有必要进行深入分析,以便从中吸取经验和教训。

理解AI回答的概率性

要明白,AI模型生成文本是依据概率分布来进行预测和采样的。以询问天气为例,同一时间点,由于概率采样的不同,可能会预测出不同的天气情况。当涉及到更复杂的输入文本时,情况会更加复杂,多种因素交织,导致结果出现差异。比如,向AI询问旅游推荐地,由于概率的影响,可能会得到多种不同的选择组合。

了解这一概率性,能让我们更理智地对待AI的回答。若仅凭一次回答就做出判断,出错的可能性很大。比如,在做出关键的商业决策时,若仅依赖AI的一次市场分析结果,没有意识到其概率性,盲目地相信,就有可能遭受损失。

AI回答差异的影响因素

AI的回答可能会出现差异,这有多种原因。首先,训练过程中吸收的资料多样性会导致它从不同角度进行回答。举例来说,在处理历史知识问答时,对于同一事件,AI可能会根据所学到的不同资料给出多种解读。此外,编码方式的不同也会影响模型的理解,就好比一个英文单词,英式和美式的编码方式可能会使其理解产生偏差。

微调确实能导致回答有所变动。以艺术创意类回答的优化为例,经过一次微调,可能会提升色彩描述的精准度;而另一次微调,则可能转换风格描述的侧重点。因此,我们不应仅期望模型每次都能提供完全相同的答案。

Sam事件中的错误判断

Sam身为OpenAI的领导者,不应忽视AI回答的随机性。他截断Grok2的回答,并据此指责其不公正,这样的做法显得过于草率。如果他能够多进行几次测试,或许就能发现Grok2的不同回答。

当他指责Grok2时,若他意识到自己所见可能只是众多结果中的一例,便不会做出那般低级的举动。类似情形在企业决策中亦时有发生,某些领导者仅凭一次观察便对全局作出判断,往往带来不良后果。

解读AI结果的正确方式

面对AI的回答,不可直接采纳。需经过反复测试与对比。比如,在查询某商品性价比时,应多次向AI提问,综合多轮结果。同时,也要留意回答中的模糊之处,对不确定的内容进行深入挖掘。

不能仅依靠单一的人工智能模型。各类AI模型在数据来源和算法上存在差异。从事新闻信息真实性核查的人员,若仅使用一个AI,可能会受到误导,应当结合多个AI工具和实际情况来进行判断。

深入探究模型背后的编码

编码对AI的回答有着显著的影响,对此,我们不妨尝试去深入理解编码的原理。例如,我们可以通过学习一些基础的AI编程入门课程,掌握编码的基本逻辑。这样一来,当我们遇到问题时,就能够大致推断出编码可能对结果造成的影响。

在设计问卷涉及AI主题时,需从编码层面预先考虑措辞,以免编码导致理解上的误差。这就像翻译外语一样,若能理解其结构,便更有助于准确传达其含义。

从事件中总结教训

Sam这件事给我们敲响了警钟,无论是职场还是生活中,我们在做出判断时都应深思熟虑。大家是否有过仅凭一面之词或一瞥之见就急于得出结论的经历?愿此事能让每个人学会对待表象时更加慎重。同时,各个领域的从业者,尤其是那些与人工智能打交道的人,更应谨慎言辞,在作出判断时需更加全面。我们鼓励大家将这篇文章传播给更多的人,也期待在评论区听到你们的观点。

内容来自网络,如有侵权,联系删除。

猜你喜欢

发表评论

电子邮件地址不会被公开。 必填项已用*标注