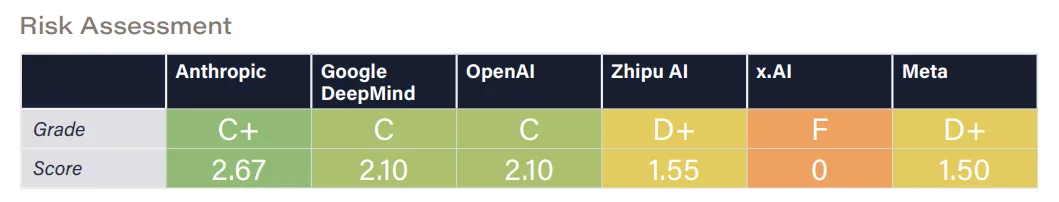

人工智能持续成为热点,其安全性问题尤其引人关注。尽管Anthropic的C级安全评级看似不低,但实则暗示了包括该公司在内,众多人工智能企业在安全操作上仍有提升空间。这一问题关乎人工智能在人类社会的未来走向,自然备受各方瞩目。

安全评级低的启示

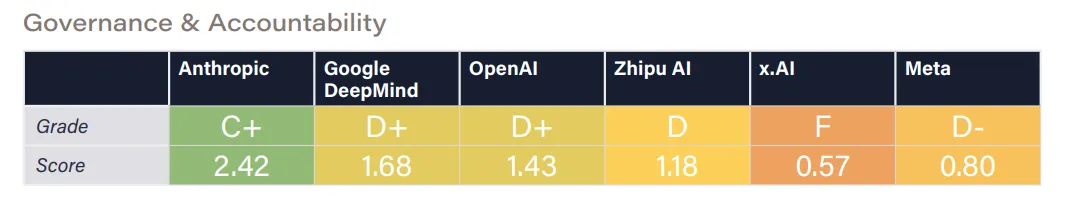

Anthropic即便获得了最高的安全评级,评级却仅为C级,这反映出目前人工智能领域的安全状况并不理想。连Anthropic这样的领先企业都只是C级,其他企业的状况可能更为严峻。实际上,许多公司的安全系统可能存在众多缺陷。比如,有些公司在用户数据保护方面做得不够,容易导致用户隐私被泄露。因此,各公司都应重视这一情况,尽快提升安全措施。不良的安全实践可能会导致人工智能生成的内容被滥用,例如虚假信息被人工智能广泛传播。

安全等级揭示了安全措施可能存在严重缺陷,因此我们必须重新审查我们的安全体系结构。技术和管理两方面都需要进行全面检查。记得有家公司因安全体系漏洞,遭受了人工智能系统的恶意攻击,这件事对其他公司来说是个警示。

扩大研究规模范围

评审专家提出,行业应拓展研究规模和领域,这一建议颇具现实价值。鉴于人工智能发展迅猛,新的潜在风险也在不断涌现。因此,企业有必要加大研究投入。例如,增加人力配置,在中国,不少人工智能企业已设立专门的安全研究小组。这些团队致力于探究人工智能在各种应用场景中的安全性,如金融、医疗等行业。

研究范畴需要扩大。不能只关注软件层面的安全,硬件方面的安全同样关键。比如,某些人工智能设备在高温等极端条件下,可能会丢失信息或遭受恶意攻击。因此,从设备运行环境到网络传输环节,都必须确保安全措施到位。

建立风险阈值标准

确立清晰的风险承受度界限极为关键。当前,业界在这方面存在不足,众多企业多凭直觉行事。在欧洲部分国家,正积极倡导制定与人工智能安全相关的法规,其中涉及风险承受度标准的设定。若能形成此类标准,企业便能够明确了解自身应采取哪些必要的安全措施,以及何种程度的风险是可接受的。

在实际操作中,企业需依据自身行业特性设定差异化的风险标准。以从事人工智能教育服务的公司为例,它们对风险的容忍度不宜过高。毕竟,这类公司服务的对象是学生,一旦发生安全事故,极可能引发严重的社会后果。相对而言,那些提供基础游戏服务的人工智能企业,其风险标准则可适当放宽,以适应不同业务的具体情况。

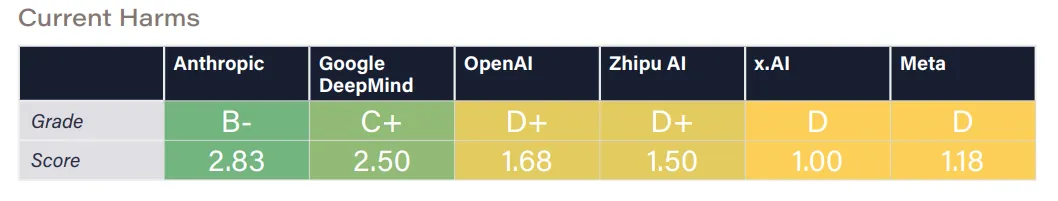

避免用户数据用于训练

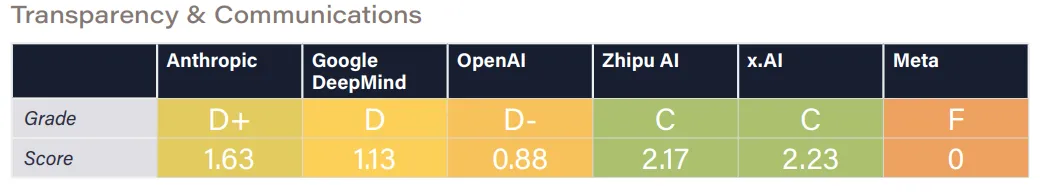

Anthropic和智谱在默认设置中未将用户交互数据用于模型训练,这种做法值得学习。用户数据中蕴含大量隐私信息。印度人工智能领域曾因用户数据被用于训练而引发投诉事件。各公司应反思自身做法。

为防止此类问题,企业应设立专门的数据管理体系。在人工智能模型训练之前,需对数据来源进行细致审查。不得采用任何来源不明的或可能侵犯隐私的用户信息。合法的非隐私数据,在使用前亦需获得用户授权。这样做既体现了对用户权益的尊重,又能有效规避诸多法律隐患。

强化外部审查监督

安全体系需要得到坚实的第三方审查和监管体系的支撑。美国部分人工智能企业会定期邀请外部机构进行审查。这样的外部监管有助于防止企业内部出现自我粉饰或忽视安全问题的现象。

审查过程中,需对公司的安全体系进行全方位评估。这包括对数据保护、系统控制能力等多角度的审查。审查方需具备相应的专业技能。同时,公司应主动配合外部审查,发现问题后迅速进行整改。若不及时处理,问题恶化可能导致重大损失。

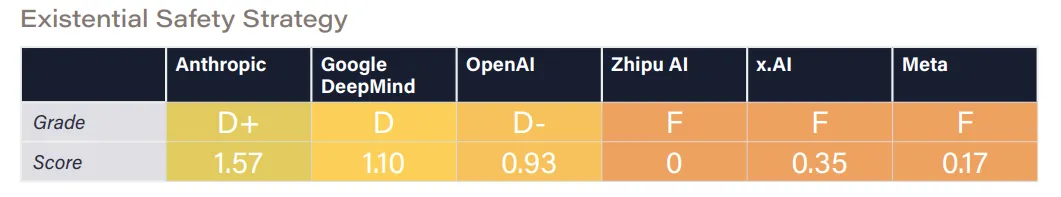

生存性安全研究不足

在生存性安全策略领域,只有少数企业进行了较为深入的研究。尽管不少企业宣称要研发AGI或超级智能,但在确保系统可控性和遵循人类价值观方面,他们的努力却相当有限。以日本为例,人工智能在协助进行重要决策时,就暴露出了价值观偏差的问题。

各家公司应予以关注,并与学术界等各方携手,共同确立符合人类价值观的方针。在人工智能的研发初期,就要将人类的价值观融入系统。此外,还需设立评估体系,对在生存安全领域的科研成就进行评价。

你对你们所用的智能服务安全有信心吗?不妨在评论区留下你的看法。同时,也请点赞并转发这篇文章,让更多的人关注并重视人工智能的安全问题。

内容来自网络,如有侵权,联系删除。

猜你喜欢

发表评论

电子邮件地址不会被公开。 必填项已用*标注