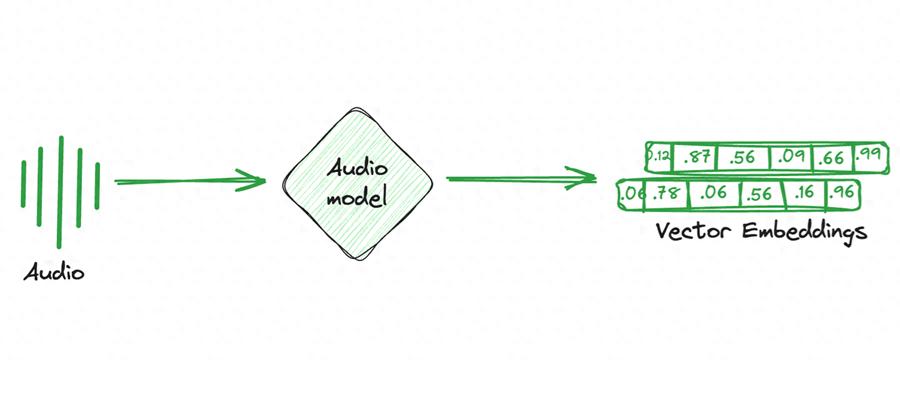

当前科技界,音频信息的处理日益关键,然而,机器如何解析繁杂的音频信息却成了一大难题。音频嵌入模型通过特定转换手段,为解决这一难题提供了方法,同时在众多领域中扮演着至关重要的角色。

音频嵌入模型基础原理

音频嵌入模型主要功能是将音频信号转化为特定维度的向量,这是其核心运作机制。比如在处理音乐时,这些模型能识别出音频中的节奏快慢、音符高低等反映时间与频率的数据。同时,它们还能捕捉到空间特征,这在处理多声道音频等复杂情况时尤为重要。在现实应用中,许多音频编辑软件的后台都运用这一原理对音频进行初步分析。每种音频嵌入模型都是基于这一基本原理来发展其后续功能的。

不同模型各有其特点。有的模型在深入解析音乐特质方面更为出色,这有助于在音乐推荐中发挥更大效用。以索尼音乐为例,它可能会运用适合的音频嵌入模型来剖析音乐,进而向用户推送他们偏好的音乐。

import numpy as np

import tensorflow as tf

from vggish import vggish_input, vggish_postprocess, vggish_slim

# Step 1: Convert audio to log-mel spectrogram

log_mel = vggish_input.wavfile_to_examples('example_audio.wav')

# Step 2: Load VGGish model

model_path = 'vggish_model.ckpt'

with tf.Graph().as_default(), tf.compat.v1.Session() as sess:

vggish_slim.define_vggish_slim()

saver = tf.compat.v1.train.Saver()

saver.restore(sess, model_path)

# Step 3: Run the model and get embeddings

features_tensor = sess.graph.get_tensor_by_name('vggish/input_features:0')

embedding_tensor = sess.graph.get_tensor_by_name('vggish/embedding:0')

embeddings = sess.run(embedding_tensor, feed_dict={features_tensor: log_mel})

print(embeddings.shape) # Output: (n, 128)

模型分类和任务支持

各种音频嵌入模型针对不同的任务进行了优化。谷歌开发的VGGish就是一个典型的例子,它被用作音频特征的提取工具,主要应用于环境声音的分类等任务。比如,在自然保护区对环境声音进行分类和监测时,VGGish模型就能派上用场。它从音频中提取的关键特征,为这些分类任务提供了坚实的基础。而OpenL3则运用了多模态学习技术,能够从音频和视频数据中提取出相关的联合特征,这使得它在音频与视频联合分类等多模态任务上拥有显著的优势。比如,在电影制作过程中,对音频和视频的同步处理就可以利用这种模型来实现。

import openl3

import soundfile as sf

# Step 1: Load audio

audio, sr = sf.read('example_audio.wav')

# Step 2: Compute embeddings

embeddings, timestamps = openl3.get_audio_embedding(audio, sr, content_type='music', embedding_size=512)

print(embeddings.shape) # Embedding vector dimensions: (n, 512)

YAMNet是一款专为资源有限的环境量身打造的模型,它适用于嵌入式设备中的实时音频处理。例如,在智能家居设备监测周边环境声响时,就可以运用到YAMNet。这些模型根据不同场景的需求进行定制,且在各自应用领域均展现出优异的性能。

典型模型实例剖析

import tensorflow as tf

import yamnet

import soundfile as sf

# Step 1: Load YAMNet model

model = yamnet.yamnet_model()

model.load_weights('yamnet.h5')

# Step 2: Load and preprocess audio

audio, sr = sf.read('example_audio.wav')

waveform = yamnet.preprocess(audio, sr)

# Step 3: Predict embeddings

scores, embeddings, spectrogram = model(waveform)

print(embeddings.shape) # Embeddings shape: (n, 1024)

以VGGish为例,这个模型是基于VGG网络的经典架构构建而成。在实际运用中,通过查看其代码实现,我们可以更深入地了解其工作原理。在处理环境声音分类任务时,运行其示例代码,我们可以观察到它如何对收集到的声音数据进行详尽分析,提取关键特征并完成分类。此外,OpenL3模型不仅适用于音频分类,还常用于事件检测,尤其在监控视频与音频结合分析场景中极为有效。例如,在机场监控区域,工作人员需同时监控视频和音频信息,以判断是否发生特殊事件,此时OpenL3模型便能发挥重要作用。

YAMNet体积小巧,特别适合小型边缘设备,比如传感器。这类设备通常计算能力不强,而YAMNet却能以较少的能耗快速完成音频事件的检测等任务。在工厂的安全监控中,小型监测传感器就可以利用YAMNet来识别是否有异常声音。

模型的开发主体多元性

import mooer

import soundfile as sf

# Step 1: Load audio

audio, sr = sf.read('example_audio.wav')

# Step 2: Generate embeddings

embedding = mooer.get_embedding(audio, sr)

print(embedding.shape) # Output: (n, 256)

音频嵌入模型涉及多种开发方。谷歌推出了VGGish和YAMNet,这两款模型各有其特点。比如,VGGish通过利用网络结构的优势来提取特定的音频特征。另外,MetaAI(前身为FacebookAI)开发的Wav2Vec主要应用于语音处理领域。它通过自监督学习从原始音频中提取嵌入特征,这一技术革新使得它在语音处理的多个应用场景中表现出色。IBM开发的MAXAudioEmbeddingGenerator则适用于快速搭建音频分析任务的原型系统,在企业和研究机构早期进行音频分析项目探索时,能起到重要作用。

不同开发方依据各自的技术储备和具体应用场景,打造了风格各异的模型,从而推动了音频嵌入模型领域的多样化进步。

import requests

# Step 1: Prepare the audio file

file_path = 'example_audio.wav'

url = 'http://localhost:5000/model/predict'

# Step 2: Send request to IBM MAX API

with open(file_path, 'rb') as f:

response = requests.post(url, files={'audio': f})

# Step 3: Get embeddings

embeddings = response.json()['predictions']

print(len(embeddings)) # List of embeddings for the audio

特定场景下的模型选择

在音乐推荐环节,若资源丰富且需进行细致的音频特性剖析,选用能处理不同时长和种类的音频数据的模型,如PANNs,会更加适宜。至于在智能手表等边缘设备上执行基础的环境音检测任务,采用轻量级的YAMNet模型会更为理想。而在涉及多模态任务的环境中,OpenL3这类能从音频和视频资料中提取共同特征的模型则更具竞争力。

这类专注于语音助手的小型创业企业在挑选音频嵌入模型时,往往因为计算资源有限,且主要应用于语音处理,因此更偏爱那些计算效率高、针对性强的模型,比如Wav2Vec。

import torch

from soundnet import SoundNet

# Step 1: Load SoundNet model

model = SoundNet()

model.load_state_dict(torch.load('soundnet.pth'))

model.eval()

# Step 2: Load and preprocess audio

audio = torch.randn(1, 22050) # Example 1-second audio waveform

# Step 3: Generate embeddings

embeddings = model(audio)

print(embeddings.shape) # Output: (batch_size, embedding_dim)

未来发展的展望

目前,音频嵌入模型在多个领域扮演了关键角色,但改进的余地依然存在。比如,在处理像古典音乐中那些复杂的和声时,现有模型可能还不够精确。随着技术的进步,我们期待模型能更深入地理解音频中的细微语义。

import torch

from clmr.models import SampleCNN

# Step 1: Load CLMR model

model = SampleCNN(num_classes=10)

model.eval()

# Step 2: Generate embeddings

audio = torch.randn(1, 1, 16000) # 1-second audio waveform

embeddings = model.forward(audio)

print(embeddings.shape) # Output: (batch_size, embedding_dim)

跨领域的应用还需进一步拓宽。比如,在医疗行业,通过音频分析病人的呼吸声来帮助判断疾病状况。若对现有的音频嵌入模型进行优化升级,或许能开辟新的应用前景。我想请教各位读者,你们认为这样的模型在哪些尚未涉及的领域有可能实现重大突破?期待大家为这篇文章点赞、转发,也欢迎在评论区发表您的观点。

内容来自网络,如有侵权,联系删除。

猜你喜欢

发表评论

电子邮件地址不会被公开。 必填项已用*标注