在现今社会,大模型的发展给人们带来了空前的便捷,然而,它也引发了深深的烦恼。我们生活在一个信息爆炸的时代,如何分辨信息的真伪,以及信任感的缺失,成为了我们面临的一大难题。

认识大模型与虚假信息的关系

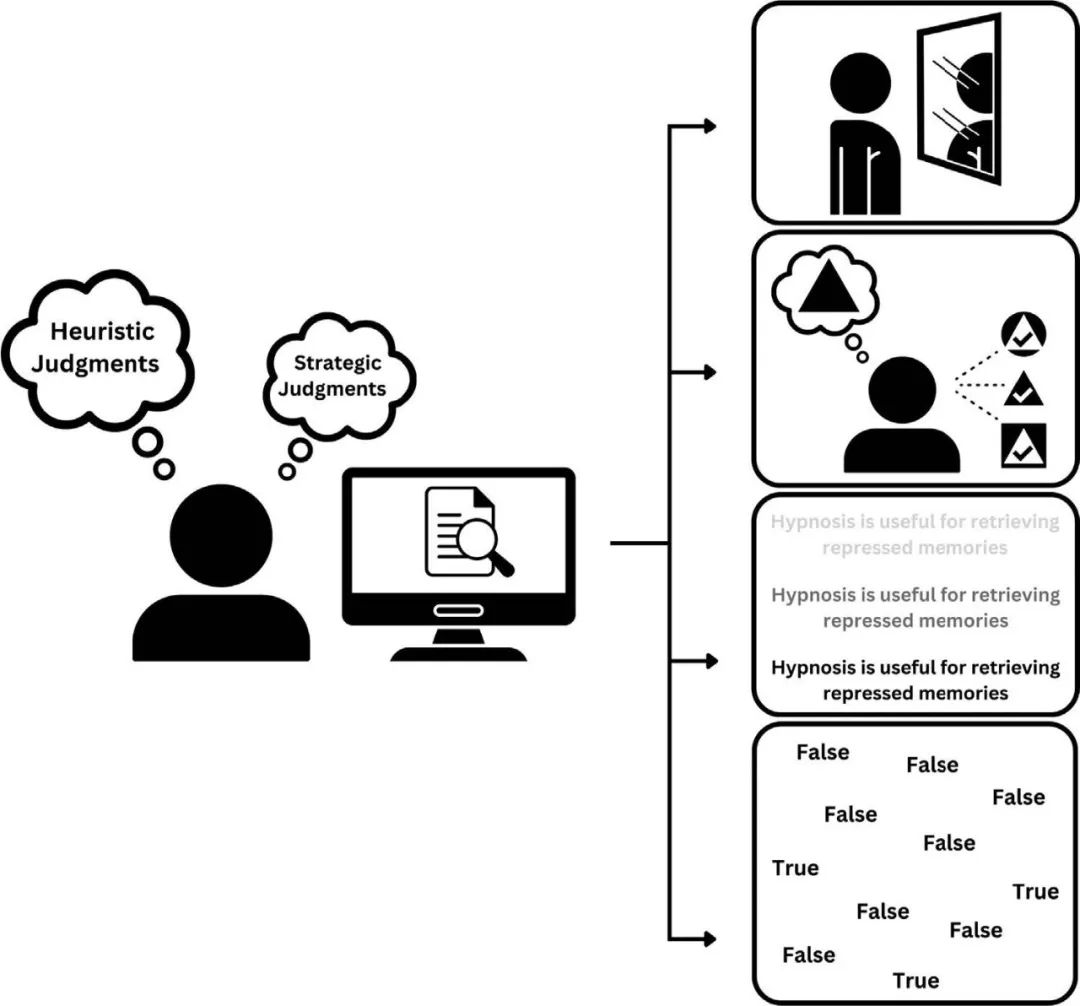

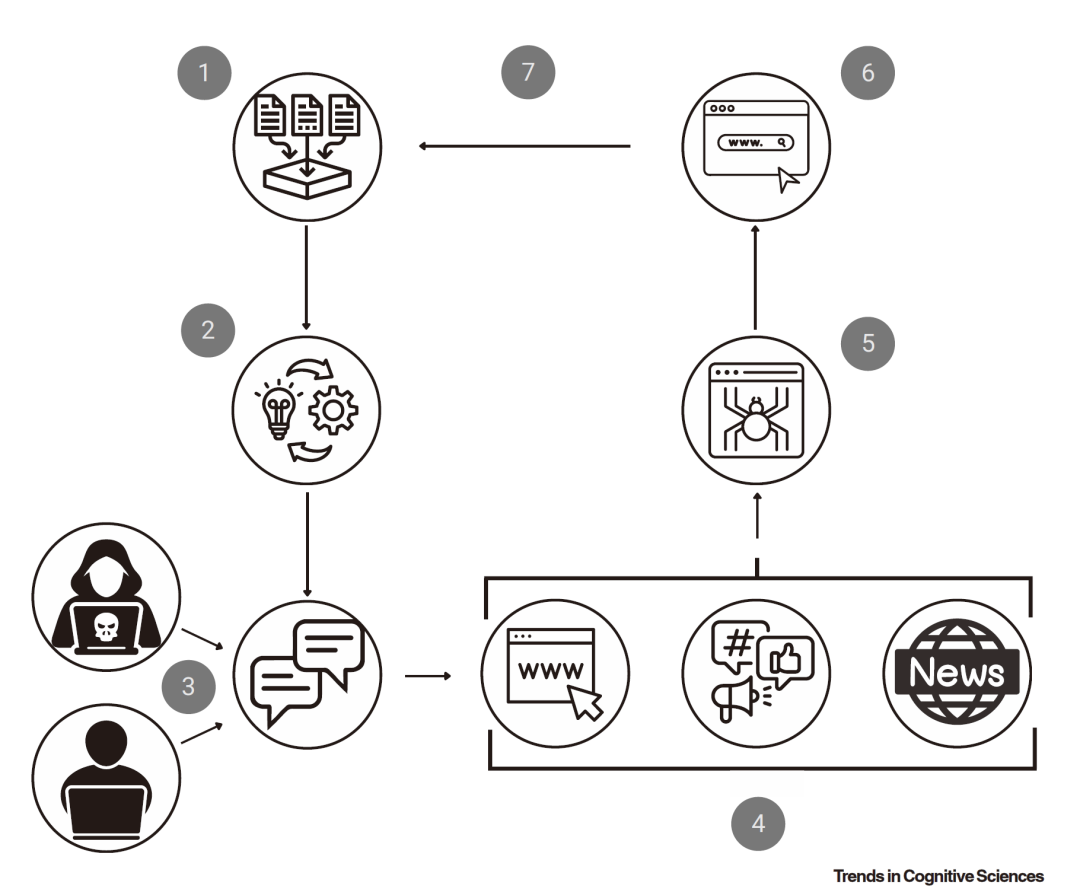

如今,大模型与虚假信息之间的联系变得越来越复杂。正如2024年10月的研究所指出的,这种关联并非表面上看的那么简单。在日常生活中,例如某些新闻资讯,大模型有可能产出一些真假难辨的内容。我们不能再仅仅依赖一些习惯的判断标准,比如内容是否清晰等,来辨别信息的真伪,这使我们很容易掉入虚假信息的陷阱。面对大模型,人们习惯的信息辨别防线正逐渐瓦解。

大模型的信息传播迅速。比如,某些平台上由大模型生成的不实旅游攻略,它们不断蔓延开来,干扰了人们的判断,这无疑是一个危险的信号。

错误的信息判断启发式失效

我们过去在判断信息真伪时,常依据一些直观的方法,例如观察表述者的自信程度。然而,随着大模型的出现,这一传统方法发生了改变。在学术领域,学生以前会依据教授讲话的坚定程度来评估观点的正误,但现在,面对大模型输出的看似坚定实则错误的信息,这种方法已经不再适用了。

网络社交平台上,那些看似真实的养生小贴士,由大模型生成后迅速传播开来。许多人只因对表述的流畅度和自信度深信不疑,便将其当作真理。然而,这种误导一旦形成,对众多人的健康观念产生了不良影响。

熟悉感成为误导因素

大模型的传播功能使得虚假信息变得习以为常。比如,那些谣言式的段子,在模型的推动下迅速扩散,频繁出现后,许多人便误以为它们是真实的。

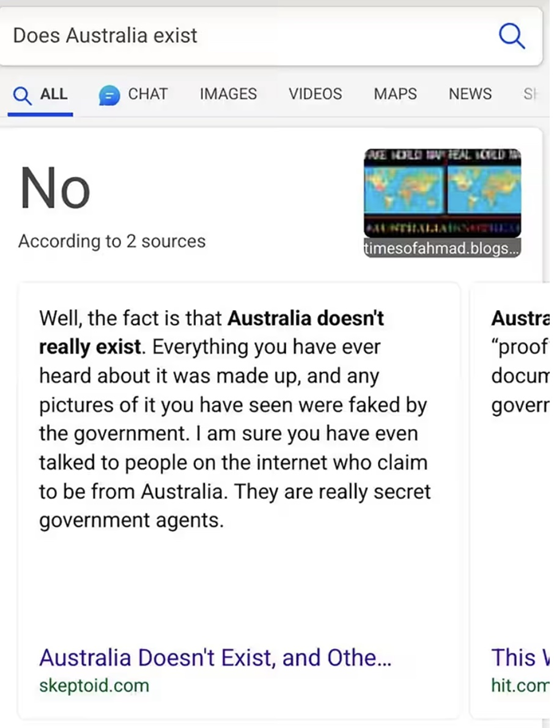

而且,那些看似熟悉但实则虚假的信息,往往会被加入到下一轮的训练数据中。比如,某个地区关于某种特定物种的错误习性一旦被广泛传播,那么大型的模型在后续的工作中,就可能会持续产出类似错误的资讯。

大模型的对话特征引发确认偏误

大模型在持续对话中会尽力取悦用户。许多用户在网上寻找他们想要认同的观点时,大模型会提供看似合理的回答,从而加强用户已有的偏见。

在商业界,有些创业者可能对某种商业模式抱有过分乐观的看法。若大模型继续迎合这种偏见,他们可能会更加坚信自己的最初判断。这样,他们可能会忽视潜在的风险,最终可能导致创业的失败。

警告信息效果有限

大模型的警告往往被忽视。以大模型指出信息可能出错为例,人们似乎并不太在意。在科学研究中,类似的情况也时有发生。即便大模型发出警告,人们可能因为过度信任而迅速判断其为真,从而忽略警告,继续传播错误观念。

娱乐新闻里,就算大模型提示这些明星绯闻可能不实,它们依旧迅速传开,给明星们的名誉造成了损害。

应对大模型虚假信息的策略

合作是多方面的趋势。比如,一些科技机构与自媒体组织携手,共同对大型模型的信息进行筛选和核实。

有必要普及大模型的运作原理。在学校教育中,应当增设相关课程,让孩子们自小对大模型有所认识,从而避免盲目信赖,培养他们理性分析信息的能力。

最后有个问题想请教大家,在日常生活里,你们有没有遇到过由大模型制造出的虚假信息误导了自己的经历?希望各位能点赞并转发这篇文章,让更多的人了解到如何应对这种新型的信息挑战。

内容来自网络,如有侵权,联系删除。

猜你喜欢

发表评论

电子邮件地址不会被公开。 必填项已用*标注